釜山行2在线观看韩剧网(釜山行2正片免费观看韩剧网)

cac55 2025-11-03 18:38 12 浏览

纵观韩国电影历史发展历程类似于《釜山行》这种折射人性题材的,以及丧尸这种超前题材,利用所知列举一二:

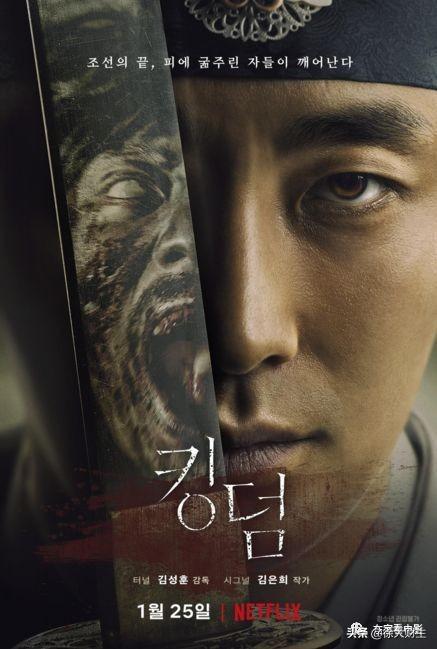

1、《王国》

该讲述君王死而得生,王世子(朱智勋 饰)在调查瘟疫疫情过程中,发现众人都陷入危险之中。《王国》(Kingdom)是一部惊悚僵尸史剧,改编自金恩熙于两年前创作的网络漫画作品《神的国家》。在一个充斥着贪腐和饥荒的王国中,关于国王死亡的神秘传闻沸沸扬扬,同时一场奇怪的瘟疫传播开来,感染者可获得不死之身并嗜食人肉。成为阴谋牺牲品的皇太子开始踏上揭露邪恶阴谋,拯救子民的征程。

2、《猖獗》

《猖獗》讲述了古代王子带兵与名为“夜鬼”的僵尸战斗,拯救国家的故事,玄彬饰演了在国外当十多年人质后回国的王子,而张东健则饰演了手握兵权,试图进行改革的朝廷重臣。

3、《隧道》 讲述了隧道内外发生的故事。河正宇在片中饰演了被困在崩塌的隧道内的男主人公正秀,是一个平凡的爸爸,为了活着回到妻子与女儿的身边,将使出全力逃命。裴斗娜饰演了正秀的妻子世贤,内心坚强隐忍,对于突如其来的意外,仍坦然地应对。吴达庶饰演了救援部队的队长大庆,一心只想着救出正秀,拥有身为救援人员的使命感与责任心。

讲述了隧道内外发生的故事。河正宇在片中饰演了被困在崩塌的隧道内的男主人公正秀,是一个平凡的爸爸,为了活着回到妻子与女儿的身边,将使出全力逃命。裴斗娜饰演了正秀的妻子世贤,内心坚强隐忍,对于突如其来的意外,仍坦然地应对。吴达庶饰演了救援部队的队长大庆,一心只想着救出正秀,拥有身为救援人员的使命感与责任心。

4、《流感》

一群东南亚偷渡客历经艰险来到韩国,但是整个集装箱内的偷渡客几乎全部死亡,只有一人拖着羸弱的身体侥幸逃入闹市之中。殊不知此人身上携带致命猪流感病毒,短短一天时间,病毒迅速蔓延城市的各个角落。许多人在不知不觉间被感染,进而将死亡的阴影引向周围所有的人。美丽的女医生金仁海(秀爱饰)是一位单身妈妈,她不久前遭遇一场车祸,幸被消防队救援人员姜智久(张赫饰)救出,却因丢失重要论文资料而备受上司苛责。值此期间,韩国蛇头的弟弟因流感送入仁海的医院治疗,经诊断终于发现流感的起因,死尸横陈的集装箱无疑成为查找病源的关键。 未过多久,猪流感病毒成几何式爆发蔓延,坐享太平的民众面临前所未有的灾难。

一群东南亚偷渡客历经艰险来到韩国,但是整个集装箱内的偷渡客几乎全部死亡,只有一人拖着羸弱的身体侥幸逃入闹市之中。殊不知此人身上携带致命猪流感病毒,短短一天时间,病毒迅速蔓延城市的各个角落。许多人在不知不觉间被感染,进而将死亡的阴影引向周围所有的人。美丽的女医生金仁海(秀爱饰)是一位单身妈妈,她不久前遭遇一场车祸,幸被消防队救援人员姜智久(张赫饰)救出,却因丢失重要论文资料而备受上司苛责。值此期间,韩国蛇头的弟弟因流感送入仁海的医院治疗,经诊断终于发现流感的起因,死尸横陈的集装箱无疑成为查找病源的关键。 未过多久,猪流感病毒成几何式爆发蔓延,坐享太平的民众面临前所未有的灾难。

2016年的一部《釜山行》不仅创造了韩国影史上单日票房最高纪录,还成为了2016年韩国票房最高的电影,一时之间《釜山行》的热度和口碑瞬间漂洋过海传到中国,使得《釜山行》也打破了中国盗版电影的下载最高记录。

一部丧尸片为何能够创造如此票房奇迹,我认为除了其壮观的特效场面外,深刻的寓意以及丧尸片成功地本土化移植都起到了至关重要的作用。除了《釜山行》外,同为延相昊导演执导的另一部丧尸灾难动画电影《首尔站》也是可圈可点。

《首尔站》是《釜山行》的前传,讲述的是《釜山行》前一天发生的故事。虽为前传,但这两部影片在剧情上并没有过多的联系,只是同为丧尸片,同样的在批判现实。在《釜山行》中我们会因父女、夫妻、情侣、朋友、姐妹之间的爱感受到一丝温暖,但《首尔站》带给我们的只是这世间的凉薄与黑暗,当我们缺少了对他人的善意与关爱之心,那我们又与丧尸有什么分别呢?有着比《釜山行》更加深刻的立意,也会让我们思考更多,《首尔站》值得一看。

燃烧

韩国名字:??(是)|主演:柳在,史蒂文?主要产品全Jong-seo |流派:神秘,流派

在我们2018年K-movies榜单上,排在首位的电影正在燃烧。无论是艺术性还是娱乐性,它都可能在韩国电影史上赢得重要的地位,与《老男孩》等经典影片齐名。

改编自村上春树的短篇小说,燃烧的文件之间的互动三个年轻的韩国人:钟苏,海米,和本。影片一开始,钟苏(柳亚仁饰)就遇到了海蜜(郑钟熙饰),一个来自他的农村家乡朴州的儿时好友。两人逐渐亲密起来,但在非洲的长期旅行后,海蜜带着一个神秘的男友本(史蒂文·杨饰)回来了。

乡巴佬钟苏根本不是世界性的本的对手。除了争夺海蜜的芳心,两人还体现了韩国社会的不同两极。作为一名有抱负的作家,钟苏试图摆脱农村成长过程中的社会经济绝望,但未能成功。另一方面,有着完美雅皮士皮肤和江南区的豪华公寓,本觉得自己像个韩国人帕特里克·贝特曼(Patrick Bateman)。当被问及以什么为生时,本不屑一顾地回答:“我打球。”

海蜜本人在一些村上春树式的方面很特别,但在另一些方面也很典型(“我做过整容手术,”她坦率地承认)。她时而扮演一个正在接受培训的角色,时而扮演一个高大的故事讲述者,迫使观众质疑现实。

通过这三个复杂的角色,《燃烧》塑造了一幅当代韩国灵魂的电影肖像。完美的电影摄影技术应用于空灵的地方——尤其是在Paju拍摄的场景,它提供dmz上的日落——让人眼前一亮。一个忧郁的声音景观(包括迈尔斯戴维斯插曲,将高兴村上春树的球迷)完成包。

《北境间谍》

韩国名字:??(Gongjak) |主演:黄Jung-min,李圣民,曹Jin-woong, Ju jae - |流派:间谍、戏剧

与朝鲜谈判?检查。选举干扰?检查。《北境间谍》是2018年最相关、最引人注目的间谍电影,不仅在韩国,也许在全世界都是如此。

在《北境间谍》中,资深演员黄宗民饰演一名代号为“黑金星”的韩国间谍。在电影中,黑金星必须潜入朝鲜收集有关其核计划的情报。事实证明,《黑金星》是根据20世纪90年代一位真实的间谍改编的——在我们的全面回顾中,你可以读到更多关于这位间谍北逃背后的真实故事。

这部电影在2018年4月韩朝峰会和首届美朝峰会后不久首映,这可能帮助它取得了不错的票房成绩。除了出色的上映时间,这部电影还对历史细节给予了极大的关注,并让你在紧张的气氛中保持着紧张的状态。如果你对朝鲜政治、朝鲜或间谍电影有任何兴趣,把《北境间谍》添加到你的列表中。

《与众神同行:最后49天》

韩国名字:????-???(Singwa hamkke - Ingwa研)|主演:哈他微微,Kim Hyang-gi Ju jae - Ma Dong-seok,金正日Dong-wook |流派:幻想,行动

如果没有《与众神同行:最后49天》(Along with the Gods: the Last 49 Days)作为2017年12月《与众神同行:两个世界》(Along with the Gods: the Two Worlds)的续集,任何2018年韩国最佳电影榜单都是不完整的。同时拍摄,这两部电影完全统治了韩国的票房。《两个世界》是韩国电影史上收视率第二高的电影,《最后的49天》是2018年票房最高的韩国电影。

在这部奇幻史诗中,三个死后的守护者(Ha Jung-woo, Ju Ji-hoon, Kim Hyang-gi)必须带领一个死去的人在阴间经历各种考验。一路上,守护者们遇到了一位神(马东硕饰),他揭开了他们古老过去的秘密。

《49天》讲述的是两个世界结束后的故事,比后一部电影更能塑造人物性格。49天的明星阵容给了一个极具魅力的表演,加上全面的动作场面,使这是一个非常有趣的电影。

《违约》

韩国名字:??????(Gukga-budo-eui Nal) |主演:金Hye-soo Yoo在,乔Woo-jin, Heo Joon-ho |流派:戏剧、政治、经济

如果你喜欢2015年的好莱坞电影《大空头》(the Big Short),或者只是对经济和政治有激情,那么违约将会激起你的幻想。这部韩国电影将许多韩国人认为自朝鲜战争以来最具创伤性的事件——1997年的亚洲金融危机——戏剧化。

即使你没有经济学博士学位,违约也是值得关注的。这部电影实际上更多地关注危机对人类的影响,而不是技术细节。这让普通观众能够同情韩国人在这段艰难时期的挣扎。

事实上,《违约》在韩国上映时表现非常好。该片在各大电影排行榜上高居榜首,并在11月创下了韩国电影有史以来的最高首映票房纪录。韩国观众觉得这部电影很有共鸣,东南亚(他们也经历了1997年的金融危机)和西方(他们经历了2008年的全球金融危机)的观众也会觉得这部电影很有意义。

女巫:第一部分

韩国名字:??(Manyeo) |主演:金Da-mi,乔Min-su,崔Woo-shik |流派:行动,神秘

在女巫:第一部分。《颠覆》的导演朴允贞(Park Hoon-jung)编织了一个复杂的故事,故事围绕着一个名叫Ja-yoon (Kim Da-mi饰)的高中生展开,她在一场神秘的事件中失去了童年的所有记忆。当Ja-yoon进入电视竞赛,为她苦苦挣扎的领养家庭赢得金钱时,她生活中开始出现模糊的人物。这使她重新发现关于她的过去和自我的秘密。

对于韩国电影爱好者来说,导演朴勋正(Park Hoon-jung)在2010年写了著名的恐怖片/动作片《我看见了魔鬼》(I Saw the Devil)。女巫有一些相似之处。虽然女巫的主角是一个十几岁的少年,但这部电影包含了不必要的打斗场景和整体的黑暗氛围。然而,女巫既不过分依赖恐怖,也不过分依赖血腥。相反,女演员金达美很好地把Ja-yoon刻画成一个细致入微的角色。

信徒

韩国名字:??(Dokjeon) |主演:曹Jin-woong, Ryu Jun-yeol, Kim Joo-hyuk Kim Sung-ryung公园Hae-joon |类型:动作,犯罪

惊心动魄的动作场面,黑色喜剧,以及一点艺术技巧——这是描述《信徒》的一种方式,它是今年最具娱乐性的韩国动作/犯罪电影之一。《信奉者》是香港禁毒战争的翻拍版,讲述的是一名缉毒侦探(赵金云饰)与一名以复仇为目的的黑帮成员合作,干掉了亚洲最大的毒枭。

虽然《信徒》不是一部特别情绪化的电影(嘿,它是动作片,你期待什么),但它在其他方面却出奇地复杂。一个跳动的,现代的配乐补充美丽的镜头枪战,格斗,爆炸场面;适时的情节转折会让你的注意力集中到最后。

和你在一起

韩国名字:????????(Jigeum Mannareo Gamnida) |主演:苏志燮,孙艺珍|风格:浪漫、情节剧

更喜欢浪漫或情节剧?别担心,我们已经为您报道了2018年最著名的韩剧《Be with you》。诚然,《与你同行》的情节并非特别新颖;这部电影是2004年同名日本电影的翻拍版。然而,男演员苏志燮和女演员孙艺珍将他们的明星力量用于这部韩国改编电影,赢得了许多观众的喜爱。

在《和你在一起》中,儿子叶晋扮演一个妻子,她承诺在她死后一年回到她的丈夫(苏志燮)身边。她在某种程度上遵守了这个承诺,尽管他们的重聚伴随着一些警告(即她所有的记忆都消失了)。亚洲各地的观众都高度赞赏这部电影的纯洁性,以及对不顾一切坚持不懈的真爱的刻画。然而,请注意:《和你在一起》真的是一部催人泪下的电影!

《心灵的钥匙》

韩国名字:???????(Geugeotmani美国Sesang) |主演:李Byung-hun,只要Yuh-jung,公园Jung-min |类型:喜剧、戏剧、家庭

想看一部以家庭为中心的电影吗?这是2018年最暖心的韩国电影之一。在这部电影中,李秉宪饰演一名运气不佳的拳击手,他回到家和哥哥(朴正民饰)住在一起。

虽然李秉宪经常以他的动作能力和轮廓分明的下巴线而闻名,但他与朴正民一起很好地利用了他可观的表演天赋。《心灵的钥匙》以敏感的方式描绘了错综复杂的家庭关系,为所有观众提供了一次情感上值得一看的旅程。

小森林

韩国名字:??????(Liteul Poleseuteu) |主演:金Tae-ri Ryu Jun-yeol,月亮So-ri,金Ki-joo |流派:戏剧,生活片段

《小森林》(Little Forest)是我们榜单上另一个暖心的成员,由金泰利(Kim Tae-ri,《侍女》[The Handmaiden]和《阳光先生》[Mr. Sunshine]的主演)主演。金妍儿饰演一位名叫惠媛(Hye-won)的年轻女子,她在尝试城市生活失败后回到了农村。在四季中,我们看到Hye-won重新发现了简单的生活乐趣(并做了很多美味的韩国食物)。

少了恶棍、冲突或紧张,《小森林》从日常生活的压力中提供了一个清新的休息。这是一个轻松的漫游通过美丽的自然风景,它的四幕(四季)结构是非常容易遵循。如果你想逃离这张清单上其他地方的厄运、阴郁和沉重,那就看看《Little Forest》吧。

了不起的战争

韩国名字:???(Ansi-seong) |主演:乔),南Joo-hyuk,公园Sung-woong |流派:行动,历史

史诗历史动作片在韩国的票房一直很好(例如《海军上将:咆哮的洋流》)。2018年的《激战》也不例外。正如标题所暗示的,伟大的战斗是关于一个伟大的战斗…具体来说,在公元645年安西要塞的围攻。在这次围城中,高句丽(一个古老的朝鲜王朝)的军队保卫了一个主要的要塞,抵御了成千上万的唐朝军队,使朝鲜半岛免遭入侵。

虽然《了不起的战争》并没有把所有的历史细节都写对(比如,里面有一些非常有吸引力的吹枪女操作员),但总的来说还是非常有趣的。这部电影巧妙地描绘了韩国人的战略思维,将其与《指环王》(Lord of The Rings)等电影中的动作场面进行了全面的搭配(尽管带有韩国元素)。

《摇摆儿童》

韩国名字:????(Seuwingkizeu) |主演:做Kyung-soo(交货单),公园Hye-su Jared Grimes哦Jung-se |类型:音乐,舞蹈,戏剧,战争

《Swing Kids》于2018年12月中旬发布,是我们榜单上的一个迟来的意外惊喜。作为一部音乐剧,《摇摆儿童》也融入了重要的历史和社会背景。

当红男团EXO的主唱杜敬洙(Do Kyung-soo,俗称D.O.)在影片中饰演一名头脑冷静的朝鲜士兵,名叫罗基洙(Ro Ki-soo,音译)。在朝鲜战争期间,罗基洙被关押在臭名昭著的战俘营。为了安抚不安的战俘,集中营当局命令一名非洲裔美国士兵组织一个踢踏舞小组。罗和其他几名囚犯加入了这个团体,并在舞蹈中找到了新的目标。

除了精心编排的舞蹈表演,《摇摆儿童》还对战争的残酷和种族紧张局势发表了评论。Geoje监狱的战俘们有着不同的意识形态,他们的非裔美国人顾问与他的白人上司就种族主义展开了斗争。用一种反传统的方法,让你一会儿想跟着跳舞,一会儿又想哭

丧尸电影:

僵尸世界大战、温暖的尸体、僵尸之地、僵尸肖恩、僵尸胡安、杀出狂人镇、活死人之地、惊变28天、惊变28周、美剧行尸走肉、活跳尸系列、活魔人、生人回避III吃人魔鬼、群尸玩过界西班牙的伪纪实名片死亡录像1-2 、隔离区系列、毁灭战士、我是传奇、末日侵袭、活死人的黎明、刑房之恐怖星球、魔诫坟场、鬼玩人系列、生化危机系列、活死人之夜、杀出个黎明、丧尸出笼、活死人归来、隔离区、丧家之女等。

热血新仔2

韩国的釜山行、首尔站

香港的僵尸叔叔、僵尸先生、僵尸、僵尸医生、生化寿司、鬼咬鬼、鬼打鬼、茅山僵尸拳等等

相关推荐

- 我的抗战演员表全部_我的抗战演员表全部名单

-

霍啸林,是抗战剧勇敢的抗战中的角色。由男演员杨志刚饰演。他曾经是一个不学无术的少爷。后来在父亲霍绍昌被赵金虎杀后才懂得的世间的冷暖。后来选择了抗日救国,最后被日本侵略者砍下脑袋。勇者的抗战霍啸林大结局...

- 虐到肝疼的超级虐文短篇现代言情

-

《送你一枝野百合》作者:罪加罪从校园到都市,双向暗恋,女追男+追妻火葬场,这本真的绝,甜虐交织,推拉一绝,今年看过的最好看的文。罪加罪真的好厉害,讲故事的能力很强。作者罪加罪真的好厉害,又会写甜,又会...

- 海洋天堂观后感_海洋天堂观后感一千字

-

海洋天堂结局:是大福像从前趴在父亲背上一样,伏在海龟的身上,和他一起游。他费尽心力地教大福自己坐公交车去海洋馆,在海洋馆擦地。为了不让大福感到孤独,他不惜拖着病重的身体,背着自制的龟壳扮成海龟,陪着大...

- 无敌战神林北_无敌战神林北1130

-

五年前,被陷害入狱!五年后,他荣耀归来,天下权势,尽握手中!我所失去的,终会千百倍的拿回来! 此一刻,天空之城,整个议事大厅,鸦雀无声…&nb...

- 虫儿飞原唱_虫儿飞原唱郑伊健

-

原唱郑伊健主唱,童声伴唱歌曲歌词:黑黑的天空低垂,亮亮的繁星相随,虫儿飞,虫儿飞,你在思念谁。天上的星星流泪,地上的玫瑰枯萎,冷风吹,冷风吹,只要有你陪,虫儿飞花儿睡,一双又一对才美,不怕天黑,只怕心...

- 黑莓视频_黑莓视频素材

-

看视频没问题!只是他是四方屏幕,不能满屏观看,而且屏幕又小!这个黑莓打电话发信息上上网还是可以的。看视频就一般般啦!

- 最霸气的十首诗_笛子最霸气的十首诗

-

一生必读的十首霸气古诗词有:《观沧海》、《赤壁》、《过零丁洋》、《夏日绝句》、《石灰吟》、《满江红》、《赴戍登程口占示家人·其二》、《从军行》、《雁门太守行》和《无题·龙卧千江水自流》。这些诗词或表达...

- 你是我藏不住的甜_你是我藏不住的甜最新章节

-

第五十四章!小说甜而不腻,有些接地气,作者文笔流畅,句句写进人心,情节套路新颖,不是烂大街的剧情,在读的时候,最大的体验就是感觉书里出现的那些人好像我们身边也有。《偷偷藏不住》刚开始看到书名的时候,我...

- 神级奶爸免费阅读全文_神级奶爸格格党

-

尚不清楚。因为张汉是一个虚构角色,他的结局取决于他的作者和故事情节的发展。如果现有的小说或影视作品已经完成,那么可以据此判断他的结局;如果还有未完成的作品,那么他的结局还不确定。需要等待后续的剧情发展...

- 哆啦a梦主题曲歌词_哆啦a梦主题曲歌词罗马音

-

1:“?”是的,我给你讲一下哆啦A梦主题曲的国语版歌词。1,哆啦A梦主题曲的国语版歌词是这样的:小小的希望被星星守护夜空之下未来是创造这世界的奇迹用画笔绘出期待与创意将...

- 十大最强机械怪兽_十大最强机械怪兽实力排行

-

金谷桥,艾雷王,艾斯杀手,机械哥莫拉,我现在只想起来这些1嘎拉蒙不是机器怪兽。2嘎拉蒙是一个虚构的角色,不是真实存在的机器怪兽。他是一只来自外太空的生物,具有超能力和变形能力。3嘎拉蒙在动画片和...

- 绝密押运40集免费观看_电视剧绝密押运全集

-

是假象的卧底,其实都是蝴蝶帮干的,武警没有卧底只是赵野是警察安在银行的卧底而已私家车恶意插队是在第二集。绝密押运第二集剧情:陶涛到九中队报到,被分配到警卫连。九中队军容整齐,军纪严明,营区内布满...

- 海之边夜未增减板全季_海之边境

-

大海是有边的。虽然说大海看起来无边无际,但它总是有尽头的。太平洋是最宽广的,但它的东边是美洲,西边是亚洲,北边是白领海峡,南边一直到南极洲,它也是有头的。其他有印度洋,北冰洋,大西洋,它们也都是有尽头...

- 夏至桑旗全文免费阅读_夏至桑旗免费阅读目录

-

《初婚有错》女主夏至,男主桑棋。作者芭了芭蕉。简介:年轻貌美的女记者忽然怀孕了,孩子不是老公的。当做金丝鸟被圈养,却不知道对方是谁;有一天晚上,一个人爬上了她的床,“怎么是你”桑旗开了一家绣坊,夏至辞...

- 权力的游戏第7集完整版_权力的游戏第1集完整版

-

1、史塔克家族的北境王国2、霍尔家族的河屿王国(河间地+铁群岛)3、艾林家族的山谷王国4、杜兰登家族的风暴地风暴王国5、兰尼斯特家族的西镜凯岩王国6、园丁家族的河湾地河湾王国7、纳梅洛斯·马泰尔家族的...

- 一周热门

- 最近发表

- 标签列表

-